高效整合与智能洞察 大数据分析与信息系统集成的实施路径

大数据分析与信息系统集成服务是现代企业数字化转型的核心驱动力。它们相辅相成,信息系统集成为大数据分析提供高质量、多源的数据基础,而大数据分析则赋予集成后的系统以深度洞察与智能决策能力。要成功实施这一过程,需遵循一套系统化、分阶段的科学方法。

一、明确业务目标与需求分析

任何技术项目的起点都应是业务本身。必须与业务部门紧密合作,明确希望通过大数据分析解决的具体问题或实现的商业价值,例如提升客户留存率、优化供应链效率或预测市场趋势。梳理现有信息系统的状况——包括ERP、CRM、SCM等各类系统——识别数据孤岛、接口不兼容、性能瓶颈等集成难点。清晰的需求与现状评估是制定后续所有技术方案的基础。

二、设计整体架构与集成方案

基于需求,设计一个灵活、可扩展的技术架构。这通常包括:

- 数据集成层:这是核心。需选择适当的集成模式与技术。

- 批处理集成:适用于对实时性要求不高的历史数据同步,常用ETL(提取、转换、加载)工具如Apache NiFi, Talend, 或云服务商提供的Data Pipeline服务。

- 实时/流式集成:用于处理传感器数据、日志、交易流等,采用Kafka, Apache Flink, Spark Streaming等消息队列与流处理框架。

- API集成:通过RESTful API、GraphQL等标准化接口实现系统间松耦合的互联,这是现代微服务架构下的主流方式。

- 数据存储与管理层:根据数据特性(结构化、半结构化、非结构化)和访问模式,构建混合数据湖仓一体(Lakehouse)架构。可能组合使用关系型数据库、Hadoop HDFS、云对象存储(如AWS S3)、以及MPP数据仓库(如Snowflake, BigQuery)或NoSQL数据库。

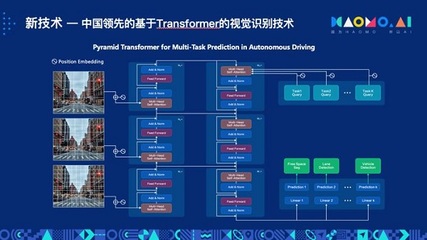

- 数据分析与计算层:部署大数据处理引擎(如Apache Spark, Hive)和机器学习平台(如MLflow, TensorFlow Extended),为上层应用提供算力。

- 应用与可视化层:通过BI工具(如Tableau, Power BI)、自定义数据应用或AI模型服务API,将分析结果呈现给最终用户。

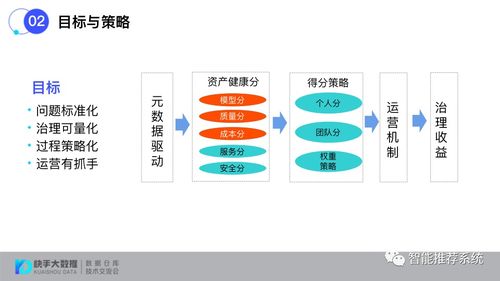

三、实施数据集成与治理

这是将蓝图变为现实的关键步骤。

- 数据抽取与清洗:从各源系统抽取数据,并执行去重、纠错、格式化等清洗操作,确保数据质量。

- 数据转换与融合:建立统一的业务数据模型(如维度建模),将不同来源的数据进行关联、聚合和转换,形成可用于分析的、一致的“单一事实来源”。

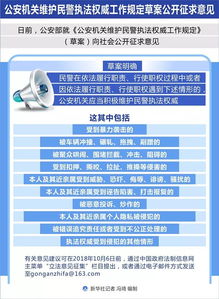

- 建立数据治理体系:定义数据所有权、制定数据标准、实施元数据管理、确保数据安全与合规(如GDPR、数据分级分类),这是保证数据分析结果可信赖和可持续的基石。

四、开展大数据分析与模型构建

在集成后的高质量数据基础上,开展分析工作:

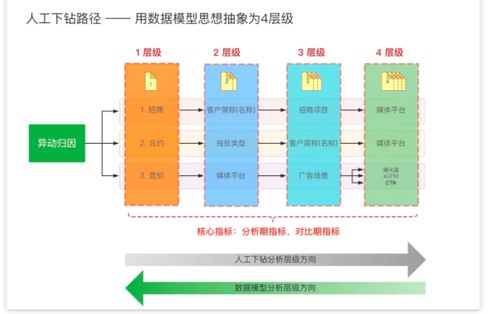

- 探索性数据分析:使用统计方法和可视化工具初步理解数据分布、关联性与异常。

- 构建分析模型:根据业务目标,应用机器学习算法(如分类、回归、聚类、推荐算法)或深度学习模型进行训练与优化。模型开发应遵循从实验到生产的MLOps流程。

- 部署与持续优化:将训练好的模型部署为可调用的服务,集成到业务系统中,并建立监控反馈机制,持续评估模型性能并进行迭代更新。

五、部署、运维与持续迭代

将集成的系统与分析能力整体上线,并提供稳定的运维支持,包括性能监控、故障排查和系统扩缩容。大数据分析项目不是一次性的,应建立敏捷的迭代文化,根据业务反馈和新数据不断优化分析模型与集成逻辑。

关键成功因素与挑战

- 高层支持与跨部门协作:这是涉及业务与IT深度融合的项目,必须获得管理层推动并打破部门墙。

- 选择合适的技术栈:避免盲目追求新技术,应选择与团队技能、现有基础设施和长期成本相匹配的工具。云服务提供商(AWS, Azure, GCP)的全套托管服务能大幅降低实施复杂度。

- 安全与隐私至上:在集成和分析全周期嵌入安全控制,对敏感数据加密脱敏。

- 人才与文化:培养或引进兼具数据工程、数据科学和领域知识的复合型人才,并建设数据驱动的决策文化。

大数据分析与信息系统集成的成功,是一个将战略、流程、技术与数据紧密结合的系统工程。它始于清晰的业务洞察,成于稳健的技术执行和持续的运营优化,最终目标是让数据流动起来,转化为驱动企业智能决策与创新的核心资产。

如若转载,请注明出处:http://www.naipu-dianchi.com/product/67.html

更新时间:2026-02-24 15:38:50